对话:中国离算力自由还有多远?

|

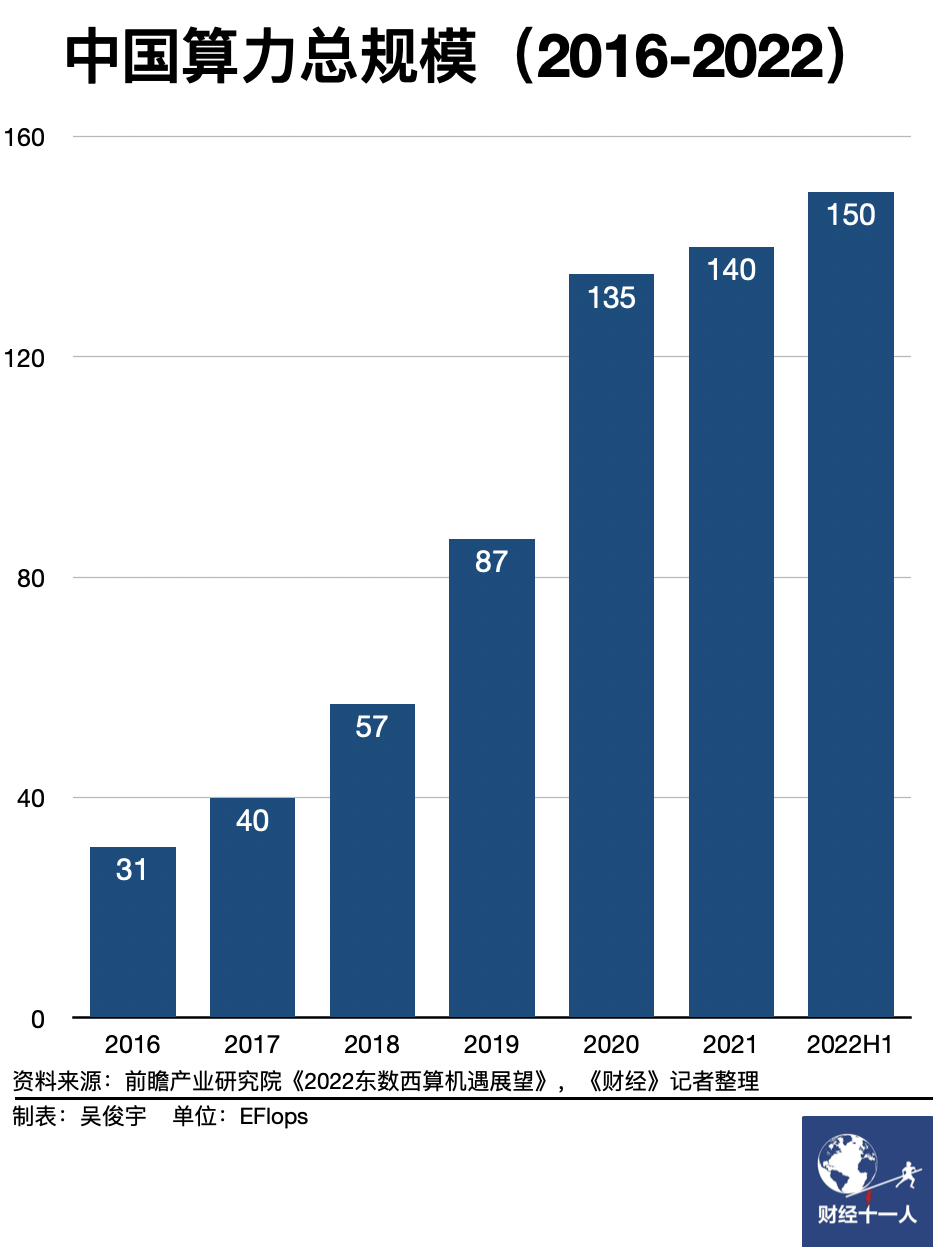

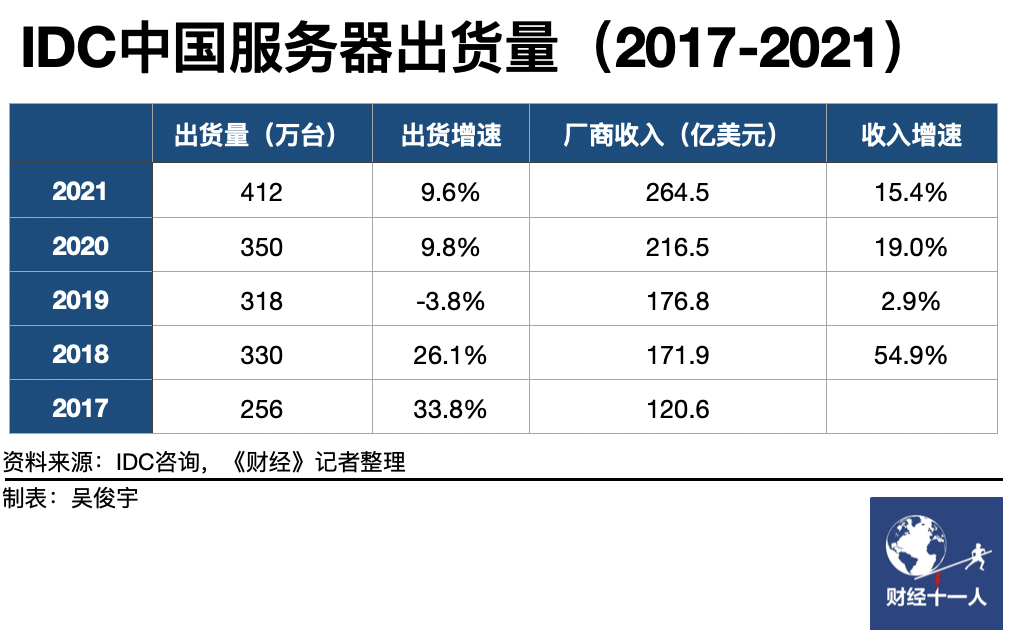

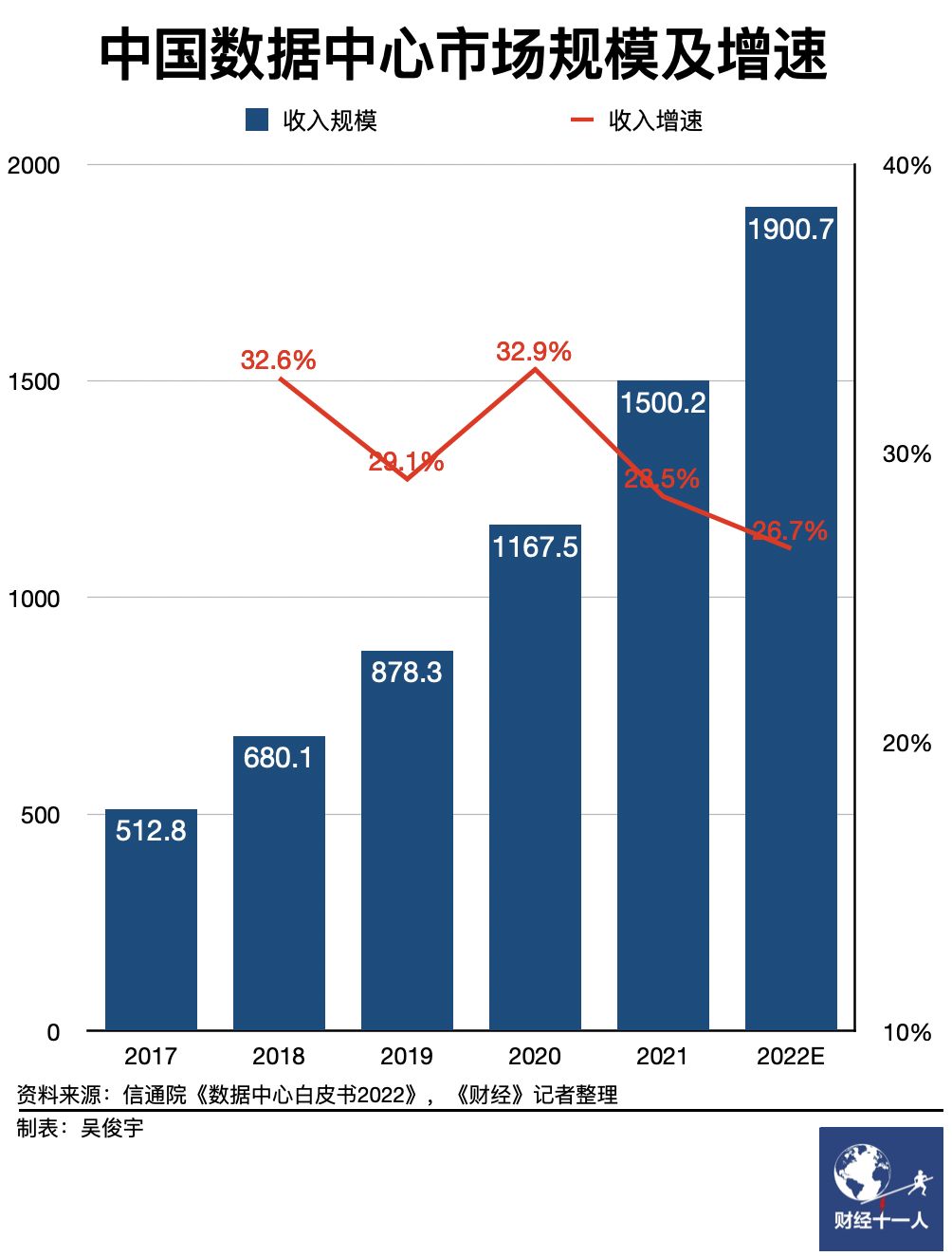

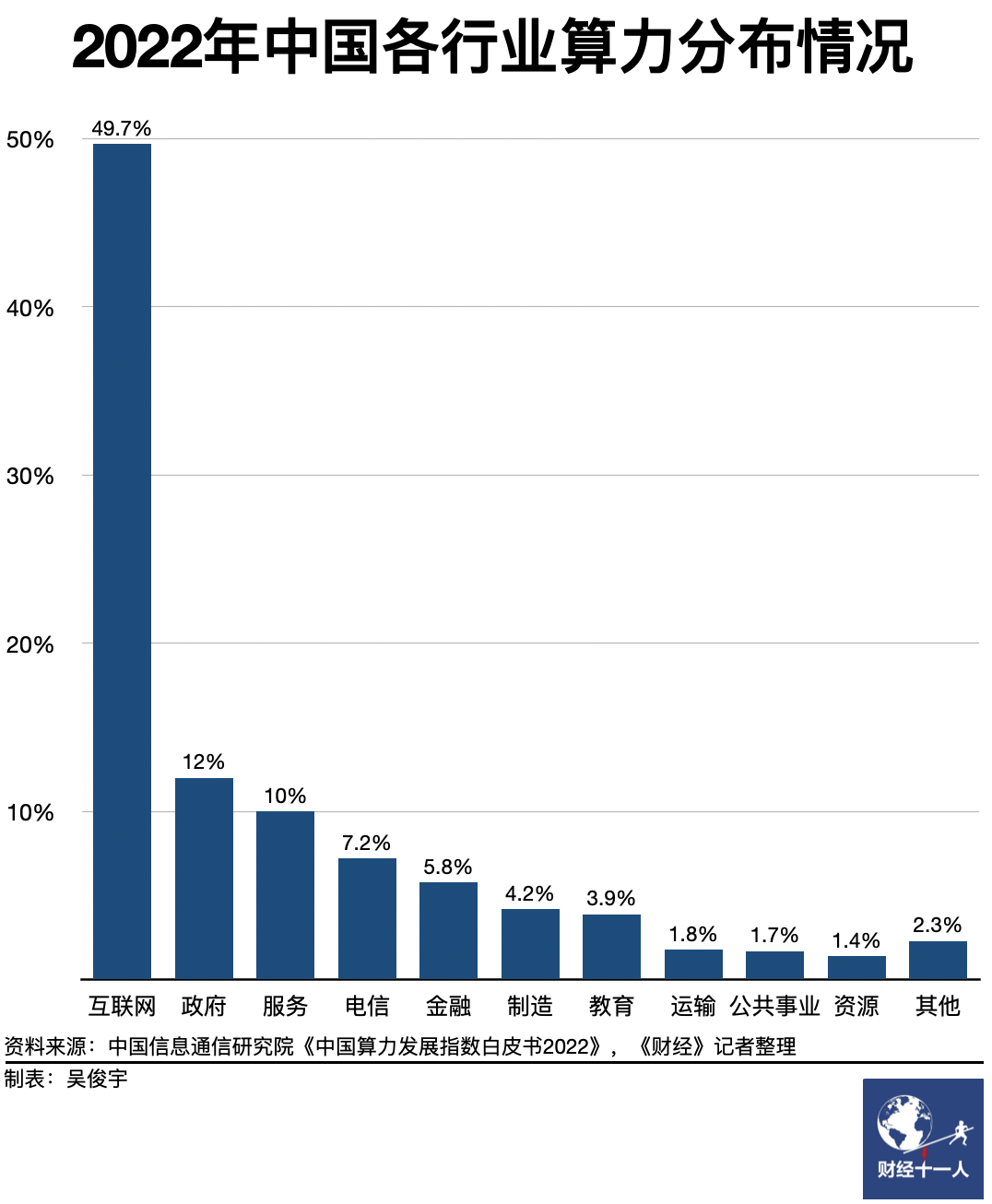

来源:《财经》杂志 算力是数字经济的底座,一个国家适度超前布局算力基础设施建设,有重要意义。 第三方市场调研机构IDC在《2021-2022全球计算力指数评估报告》中分析了包括美国、中国等15个重点国家的算力指数(根据多项指标测算的算力综合指数)得出的结论是:算力指数平均每提高1点,国家的数字经济和GDP将分别增长3.5‰和1.8‰。 每一代网络基础设施都会催生新一代产业。不同算力基础设施上,也会诞生不同的软件。3G、4G网络让移动互联网诞生。在传统的CPU算力上诞生了云。以GPU为代表的AI算力,则催生了ChatGPT和AI大模型。 2022年12月,微软投资的AI创业公司OpenAI推出了聊天机器人ChatGPT。ChatGPT本质是OpenAI自主研发的GPT-3.5语言大模型,该大模型包含近1800亿个参数。2023年3月15日,OpenAI将该大模型迭代至GPT-4.0。GPT-3.5只是单模态大模型,只能回复文本。但GPT-4.0是多模态大模型,能同时实现图像、文本输入。GPT-4.0的回复准确度、语义理解力大幅提升。 今年2月,阿里、百度等中国企业宣布将研发类ChatGPT产品,或将投入生成式AI的研发。3月16日,百度发布了对标ChatGPT的大语言模型“文心一言”。不过,目前中国企业对外发布的大模型普遍是单模态的,且普遍面临GPU算力不足的挑战。 《财经》在3月初与三位技术背景出身的专家进行了一场对话。他们经历了中国产业技术发展的不同阶段,拥有不同领域的专业视角。这场对话的主题是,“中国离算力自由有多远”。我们在这场对话中探讨了三大问题: 智能算力是什么,为何兴起?智能算力会带来哪些产业变革?中国要如何科学规划算力产业? 对话人简介: 新华三集团副总裁、计算存储产品线总裁 徐润安(新华三是国内重要的数字化解决方案提供商。新华三提供计算、存储、网络、5G、安全、终端等数字化基础设施,客户覆盖百行百业) 百度杰出系统架构师 王雁鹏(百度智能云业务2022年营收177亿元,正在成为集团的第二增长曲线。3月16日,百度发布了对标ChatGPT的大语言模型“文心一言”) 独立分析师,数字化行业专家 宁宇 主持人:《财经》杂志副主编 谢丽容 以下是对话实录精华版: 智能算力是什么,为何兴起? 《财经》谢丽容:ChatGPT的风靡让大家关注智能算力,就像多年前谷歌的AlphaGo战胜围棋世界冠军时,让普通人认识了人工智能,算力是什么?尤其智能算力是什么?它是一种什么样的资源? 宁宇:算力是通过对信息数据进行处理,实现目标结果输出的计算能力。算力会和算法、存储一起构成我们数字社会的基础。 徐润安:大众意义上理解的通用算力是CPU(中央处理器)。无论个人使用的电脑、手机,企业使用的服务器都最关心CPU主频性能。这是衡量算力的一个重要指标。但数字化正在让算力需求发生变化。CPU作为通用算力,已经无法完全满足新需求。异构算力,比如GPU(图形处理器)、DPU(深度学习处理器)、NPU(神经网络处理器)通常被用来处理AI计算的需求。所以通常也被称为智能算力。 王雁鹏:智能算力和通用算力采用了不同的计算方法。以CPU为代表的通用算力,善于执行逻辑指令进行高效率的计算。GPU为代表的智能算力,善于处理大量无逻辑关系数据的并行计算。 AI训练和推理通常不涉及复杂控制指令,却又依赖大量数据的并行运算。GPU/DPU/NPU这些专用处理器因此诞生。在过去的计算体系结构中,CPU要处理所有工作。现在的计算体系结构形成了不同的分工。GPU/DPU/NPU会针对不同的场景去做深度的优化定制。 《财经》谢丽容:ChatGPT这类AI应用正在让智能算力需求爆发。2022年中国服务器出货量约380万台,AI服务器出货量超25万台,在大盘中占比约6.5%。哪些行业、哪些领域对智能算力有强需求? 徐润安:典型的使用场景包括互联网的搜索和推荐、零售电商业务数据分析;政府的智慧城市及治理,比如新华三已经为杭州滨江、呼和浩特等60余个地市通过城市大脑进行公共事务的辅助决策;自动驾驶的仿真训练,需要大量真实道路数据进行模拟学习。 王雁鹏:百度在AI领域投入很久,云业务标签是“智能云”。我们提出了一个理念,叫AI Native(AI原生)。也就是说,千行百业都可以使用AI算力和模型训练。例如,金融机构反欺诈、钢铁工厂AI质检、能源企业的线路检修都采用了百度类似深度应用。这个趋势未来会给各行业带来翻天覆地的变化。不过,这需要一段时间。 《财经》谢丽容:这么多领域都要用到智能算力,那么资源相对充沛的通用算力是不能用,还是效率跟不上?从客户需求来看,智能算力占比已经超过甚至替代通用算力了? 徐润安:这是计算效率的问题。最常见的CPU算力是x86服务器芯片。x86芯片单核性能强、通用性好,但是AI场景通常需要多核、高并发、高带宽的芯片。综合考虑成本、效率,GPU/DPU/NPU这些专用处理器通常会处理得更好。 现代计算机是遵循冯·诺依曼架构设计的,这套架构已经延续70多年。可以确定的是,CPU作为中央处理器的地位在短期内不会改变。只是在数据挖掘等场景下,CPU的职能被其他专用芯片分担了。CPU、GPU及其他AI芯片,这三种蛋糕的比例会有变化。不过未来会诞生新的计算机架构。 现在有一种理念叫做“多元算力”。过去10年大家通常只谈x86计算架构。但计算芯片和计算进程都在多元化,这是必然的趋势。 王雁鹏:简单理解的话,CPU像是大脑,它需要完成复杂的逻辑。GPU/DPU/NPU这些专用芯片就像四肢。它们不需要脑子太发达,只需要四肢足够强壮,去解决需要解决的工作。 《财经》谢丽容:把CPU/GPU/DPU/NPU这些算力资源组合在一起,什么样的组合才是效率最高的?专用芯片是不是需要足够大的规模,成本才会下降? 宁宇:通常情况下,特殊需求一定要足够大的规模,才能支撑起专用芯片。专用芯片,需要规模化运作,才能更经济。多元算力持续增长,专用需求规模化扩张。这才会让专用芯片的研发、生产、制造需求也不断扩大。另一种场景是,传统芯片无法完成新的工作。因此,哪怕成本更高,也需要用专用芯片去解决,企业自然而然也会去使用专用芯片。 徐润安:是否使用专用芯片其实是种商业考量。所有活动都要考虑投入产出比,追根溯源还是效率问题。专门为一个算法或一个场景研发专用芯片,前提是可以产生足够的效益,最终能覆盖研发和制造成本。过去几十年,x86架构芯片的生产成本降到了很低,因此CPU无法被替代。但是大模型和其他业务场景的出现,专用芯片的综合计算效率更高,使得其他厂商有机会研发生产专用芯片。 《财经》谢丽容:专用芯片需要面临成本、效率这个矛盾。ChatGPT背后的AI大模型和生成式AI是不是也需要面临类似的矛盾?如何解决这些问题? 王雁鹏:阻碍上一代AI技术大规模落地的瓶颈有三个。一是企业需要针对不同业务场景,定制不同的算法,研发成本很高。二是,AI的后面是人工,企业需要耗费大量人工去标注数据,人力有限且成本高昂。三是,语音、图像、自然语言分别有不同的研究框架,三者无法融合。 大模型代表了新一代AI技术,带来了里程碑式的变化,解决了三个核心问题。一是,一个通用的算法就可以应对过去数十种场景,落地空间变得更大。二是,数据无需人工标注,大量数据可以得到自动训练,而且模型结构是统一的。三是,语音、图像、自然语言可以实现多模态融合,三者互相关联。AI的思考方式会更符合人类认知方式。上述三个变化,更通用的模型、大规模数据训练、多模态融合,会带来AI技术的井喷和AI应用的爆发。 宁宇:过去AI模型往往用于专业领域、专业场景。大模型让AI能够成为通用工具平台,应对足够多的场景。上层AI应用使用规模变大,会激发AI算力的需求,进而会使得下层硬件可以衍生出专用AI场景的芯片、服务器。这是一个从专业到通用再到专业的产业循环。 徐润安:AI从水平场景影响到了应用、硬件一个个不同的层次,这使得业务既解耦又打通。比如,底层的智能算力可以提供专用芯片,进一步降低上层AI应用的成本。 智能算力会带来哪些产业变革? 《财经》谢丽容:AI技术这轮演变和创新会带来大量新的机会,其中谁会受益?是不是会有一批优秀的创业公司诞生?未来会形成怎样的产业生态? 徐润安:生成式AI爆发会带来巨大的算力消耗,那么第一轮机会是ICT企业的。头部企业投入大模型研发,对新华三这种ICT企业来说就是机会。我们有更多机会服务好这些头部客户,为他们建设基础设施。 第二轮机会是头部大公司的。头部厂商开发出大模型之后,可以利用平台对外赋能。对外服务的过程,也是这些大公司受益的过程。 第三轮机会是各类创业公司的。大公司研发出大模型后,会形成平台生态。大量公司在平台上,针对千行百业研发上层AI应用。黄教主(英伟达CEO黄仁勋)说,ChatGPT相当于iPhone。iPhone带来了移动互联网的爆发,大模型也是类似的。这个过程中会有起有伏,有人成功有人失败,但一定会有最终的受益者。 王雁鹏:在AI领域,百度有芯片、框架、大模型和应用的全面积累。 我认为未来可能会形成三层生态。基础层是提供基础大模型服务的企业,只有大公司才有能力。因为这需要长期投入,如资金、人力和技术积淀。第二层主要是各领域的公司。一些公司有较强的行业研究能力,可以基于大模型做各领域的专业应用。第三层是开发者。他们只需要放开手脚,把应用做好。开发者一定是更繁荣和开放的生态。 宁宇:大模型可能会让AI产业出现类似移动互联网诞生前后的产业变革。早年通信设备商为电信运营商提供硬件,中国移动、中国联通、中国电信铺设3G、4G高速通信网络。基础设施建设完成后,移动互联网群雄并起。微信、淘宝、支付宝这些APP都因此诞生。 AI产业在中国发展很快,现在新华三这类企业为大厂提供硬件,助力建设算力中心,大厂建成大模型,大模型上会雨后春笋般孵化出AI应用。AI产业链会重构,大中小企业都可以找到自己的定位。所以,黄教主才会说,ChatGPT出现不亚于iPhone诞生给产业带来的冲击。 要如何科学规划算力产业? 《财经》谢丽容:ChatGPT出现后,国内部分企业正在开始追赶。但也有人质疑,我们的算力、算法、数据实力能不能支撑中国做好类似的应用? 王雁鹏:在AI领域,中国和美国是绝对领先的。当前中国算力的确受到了一定制约。但从长线来看,一定可以突破,我对此有信心。接下来的挑战是,数据是不是够多。客观现状是,中文数据丰富度小于英文,但模型的逻辑推理能力可以弥补这个短板。 宁宇:算力、算法、数据,这些要素其实中国都有。我们未来的问题是监管这类非技术因素。训练内容如何监管、应用场景如何适配、社会如何跟进技术发展,这都是挑战。 《财经》谢丽容:ChatGPT这类生成式AI应用和大模型正在涌现。面向未来,中国应该如何科学地规划自己的算力产业? 王雁鹏:我们希望,算力的供给能像水电一样简单。以CPU为代表的通用算力有标准的软件、接口,在云上已接近水电。但是GPU/DPU/NPU这些异构算力,软件复杂度越来越高。它的使用并不像CPU那样简单。这意味着我们需要芯片、框架、模型、应用都一体化整合发展。这样才能把智能算力也变成CPU算力一样标准化的水电资源。 徐润安:我们需要摒弃过去几十年看待算力的视角。过去是摊大饼似的买设备,堆砌算力,这种发展模式太粗放了。一方面我们需要应对多元算力的发展趋势,让算力得到更高效使用。另一方面,算力对电力消耗很大,所以这也催生了东数西算这样的政策规划。 此外,中国一直在提“算力网络”概念,思考如何把国内的数据中心跨区域连接在一起。这是个系统工程。如果算力网络建成,算力、存储、网络都可以统一调度,那么它会成为数字化变革的核心。新华三在去年推出了H3C UniServer G6新一代AI服务器,为此还搭配了智能管理中枢,这就像是算力操作系统。现在的异构算力太多了,我们希望弥补这些鸿沟,让企业能更简单、高效地使用AI算力。 宁宇:算力作为资源需要整体分配。对企业来说,需要不断降低算力成本。对国家来说,需要对产业链的不同角色进行重新定位。东数西算与碳中和等其他国家战略是相互匹配的。就像中国建设高铁、4G/5G网络一样,算力基础设施建设也要有规划。既要让成本足够经济,又要让地区平衡发展,还要协调算力基建、AI应用的供需节奏。 把分散的服务器、数据中心简单汇总计算出中国总体算力,这种统计方式便于操作。但我个人并不完全赞同拿浮点运算总数去衡量一个国家的算力能力。政策方提“算力网络”、“云网融合”概念,是因为算力相连成网络之后才有意义。这就像局域网不成体系,互联网才能创造产业价值。 《财经》谢丽容:以电信行业为例,中国普通人的的通信自由,不为流量资费发愁的日子似乎是从4G开始的。对中国来说,什么是算力自由?算力自由是什么状态? 王雁鹏:我理解的算力自由是,算力要支撑算法的发展,不要限制人类的想象力。从历史发展来看,大型机/小型机被x86架构芯片取代,原因是大型机/小型机太昂贵,无法建成互联网和云计算。互联网让廉价的x86架构芯片最终一统天下。Google在2003年-2006年发表的三篇论文又为云计算奠定理论基础——用廉价的通用计算设备(x86架构,Linux系统)搭建低成本的计算集群。每个时代都可以重构不同的计算模式。这需要百度、新华三等企业在不同领域跨产业层的努力。 宁宇:第一是便宜,第二是易用。每一代通信技术迭代的周期是10年左右。电信运营商在这个周期内,一方面要保证经营能够覆盖基站的建设、维护成本,另一方面要让用户增长和网络规模同步发展。在这两个平衡的前提下提速降费,实现通信自由。未来如果有算力运营商,或者说是今天的云计算厂商,国家需要有宏观政策指导产业演进。让资源供给、市场需求以及运营商的收入能够实现良好的匹配。 徐润安:算力自由不是简单的摊大饼,核心是供需平衡。和通信产业不同的是,通信技术10年一次迭代,但算力是3年-5年一次,因为服务器的平均使用周期大约是4年。这会导致算力运营商的成本是偏高的。算力设备采购后,3年内必须充分发挥作用。如果算经济账,这会带来很大的挑战。 关于算力的技术演进,这需要端到端的优化,产业链从上到下打破这壁垒。新华三和这类云计算厂商、三大电信运营商都需要探讨这些需求。我们不能只生产、提供设备,我们需要对未来做出预测,进行适当的投入,提前做技术布局。 |