微软推出42亿参数新AI模型Phi-3-vision,主打视觉理解

|

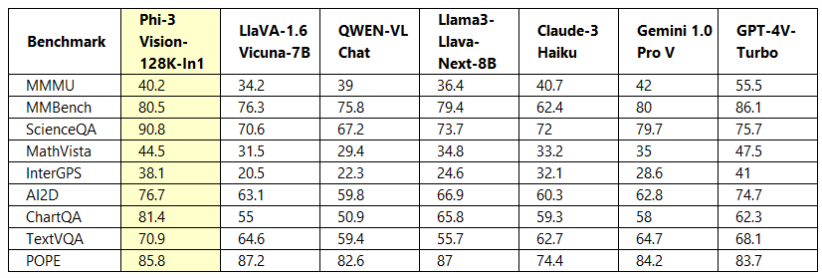

5月26日消息,微软最近推出了其小语言AI模型家族(SLM)的全新成员--Phi-3-vision。此款模型以视觉能力为主打特色,不仅能理解图文内容,还被誉为能在移动平台上实现流畅高效的运行。 Phi-3-vision模型,作为微软Phi-3系列的首款多模态模型,其文字理解能力源于Phi-3-mini,并继承了其轻量化特性,非常适合在移动设备或嵌入式系统中运行。该模型拥有42亿的参数量,这一数字超过了Phi-3-mini的3.8亿,但低于Phi-3-small的70亿。其上下文长度达到了128k token,训练周期从2024年2月持续至4月。 据本站了解,Phi-3-vision模型的最大亮点在于其图文识别能力。它不仅能够理解现实世界中图片的含义,还能迅速识别和提取图片中的文字信息。微软表示,这款模型在办公场合中表现出色,特别是在识别和理解图表及方块图方面有着出色的能力。它可以根据用户输入的信息进行推理,并为企业提供有价值的战略建议,其效果甚至可与大型模型相媲美。 在模型训练方面,微软强调Phi-3-vision是通过多种类型的图片和文字数据进行训练的,这些数据来源于一系列经过严格筛选的公开内容,如教育材料、代码、图文标注数据等,从而确保了模型能够处理多样化的输入。同时,微软也注重用户隐私的保护,在训练数据中严格排除了任何个人信息。 性能方面,微软提供了Phi-3-vision与其他竞品模型如字节跳动的Llama3-Llava-Next(8B)、微软研究院与其他机构合作的LlaVA-1.6(7B)以及阿里巴巴的通义千问QWEN-VL-Chat等模型的对比图表。结果显示,Phi-3-vision在多个测试项目中均表现出色。 目前,微软已经将Phi-3-vision模型上传至Hugging Face平台。 |