基于GPT-3的大语言模型训练任务刷新记录:NVIDIA H100加速卡仅用11分钟

|

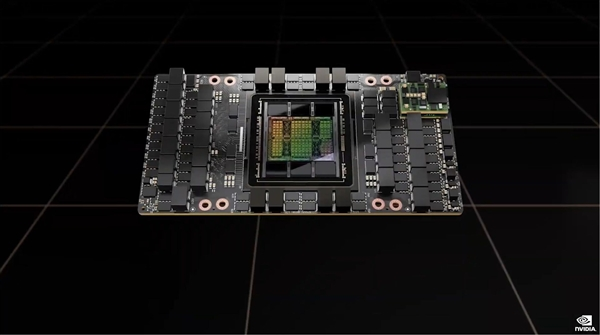

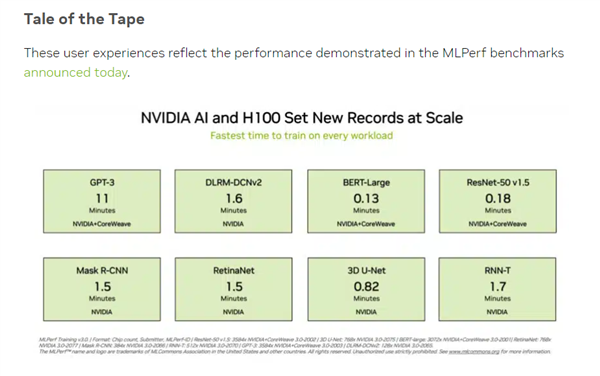

【本站】6月28日消息,AI技术的蓬勃发展使得NVIDIA的显卡成为市场上备受瞩目的热门产品。尤其是高端的H100加速卡,其售价超过25万元,然而市场供不应求。该加速卡的性能也非常惊人,最新的AI测试结果显示,基于GPT-3的大语言模型训练任务刷新了记录,完成时间仅为11分钟。 据本站了解,机器学习及人工智能领域的开放产业联盟MLCommons发布了最新的MLPerf基准评测。其中包括8个负载测试,其中就包含基于GPT-3开源模型的LLM大语言模型测试,这对于评估平台的AI性能提出了很高的要求。 参与测试的NVIDIA平台由896个Intel至强8462Y+处理器和3584个H100加速卡组成,是所有参与平台中唯一能够完成所有测试的。并且,NVIDIA平台刷新了记录。在关键的基于GPT-3的大语言模型训练任务中,H100平台仅用了10.94分钟,与之相比,采用96个至强8380处理器和96个Habana Gaudi2 AI芯片构建的Intel平台完成同样测试所需的时间为311.94分钟。 H100平台的性能几乎是Intel平台的30倍,当然,两套平台的规模存在很大差异。但即便只使用768个H100加速卡进行训练,所需时间仍然只有45.6分钟,远远超过采用Intel平台的AI芯片。 H100加速卡采用GH100 GPU核心,定制版台积电4nm工艺制造,拥有800亿个晶体管。它集成了18432个CUDA核心、576个张量核心和60MB的二级缓存,支持6144-bit HBM高带宽内存以及PCIe 5.0接口。 H100计算卡提供SXM和PCIe 5.0两种样式。SXM版本拥有15872个CUDA核心和528个Tensor核心,而PCIe 5.0版本则拥有14952个CUDA核心和456个Tensor核心。该卡的功耗最高可达700W。 就性能而言,H100加速卡在FP64/FP32计算方面能够达到每秒60万亿次的计算能力,而在FP16计算方面达到每秒2000万亿次的计算能力。此外,它还支持TF32计算,每秒可达到1000万亿次,是A100的三倍。而在FP8计算方面,H100加速卡的性能可达每秒4000万亿次,是A100的六倍。 |